DEEPFAKES Y POSVERDAD IMPONEN LA BÚSQUEDA DE EQUILIBRIO ENTRE TECNOLOGÍA Y ÉTICA SOCIAL

El auge de herramientas como las inteligencias artificiales generativas han abierto un horizonte desconocido en la generación de contenidos falsos. Su difusión genera impactos emocionales individuales y colectivos impensados. El autor de esta nota analiza posibles abordajes de esta problemática.

Por Eduardo Laens*

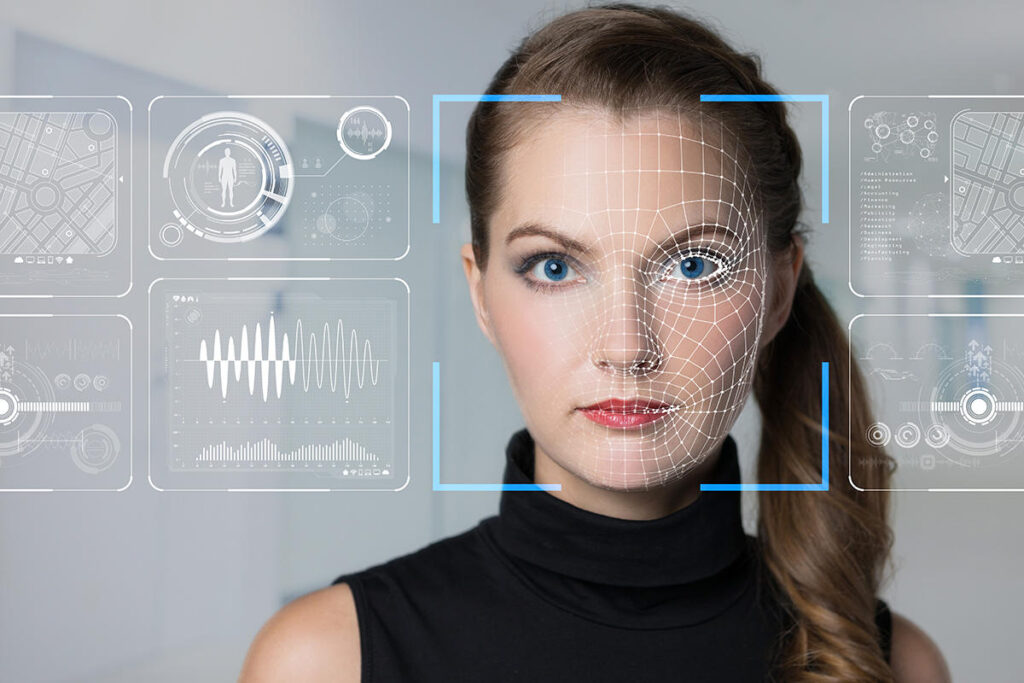

El fenómeno de los deepfakes —contenidos audiovisuales falsificados con inteligencia artificial— aterrizó brutalmente en el patio de nuestras sociedades, alterando la percepción pública y planteando serios desafíos éticos y morales. Si bien mucho se habla de los beneficios de la IA, con miles de aplicaciones positivas, su uso indebido preocupa cada vez más, especialmente cuando afecta a menores de edad y alimenta el fenómeno conocido como posverdad.

El término deepfake surge de la combinación de «deep learning» (aprendizaje profundo) y «fake» (falso), y se refiere a imágenes, videos o audios generados mediante algoritmos sofisticados que logran imitar con sorprendente exactitud a personas reales. Su impacto va desde la creación de contenido sexualizado falso hasta la difusión de noticias y declaraciones ficticias, lo que afecta gravemente la percepción colectiva de la realidad.

Recientemente se han conocido múltiples casos donde adolescentes utilizan estas herramientas tecnológicas para crear imágenes sexuales falsas de compañeros de clase, generando traumas emocionales profundos y situaciones de acoso escolar grave.

El daño psicológico causado por la circulación de estos materiales entre menores es significativo y persistente. Según estudios recientes, las víctimas de estos deepfakes enfrentan estrés, ansiedad y depresión, exacerbando problemas de autoestima y confianza personal. Los especialistas en psicología adolescente recomiendan una intervención educativa temprana y programas de concientización que incluyan tanto a estudiantes como a padres y docentes.

Pero el impacto de los deepfakes no se limita al ámbito escolar ni a los menores de edad. Adultos en todo el mundo también están expuestos constantemente a contenidos manipulados, enfrentándose a una creciente dificultad para discernir entre hechos reales y contenidos fabricados con IA. Este fenómeno alimenta la «posverdad», definida por el Diccionario de Oxford como una situación donde los hechos objetivos tienen menos influencia en la formación de opinión pública que las emociones y las creencias personales. De ese modo, nos volvemos cámaras de eco de la mentira generada por otros.

La circulación masiva de noticias falsas (fake news) reforzada con la credibilidad visual de un deepfake tiene potencialmente consecuencias desastrosas para la sociedad. Desde campañas de desinformación durante procesos electorales hasta la creación de conflictos sociales y políticos, la facilidad con la que se puede generar y distribuir contenido falso requiere atención inmediata y regulación clara.

Este fenómeno no es nuevo. Hace varios años que cientos de organizaciones globales nos alertan respecto de estas alteraciones, las cuales fueron potenciadas por la llegada de las redes sociales, ahora exacerbadas por las IAs Generativas. La abundante contaminación de contenido falso, cuyo único fin es lograr interacción, se traduce en una creciente apatía hacia el consumo de información: como todo puede ser mentira, nada es verdad.

Como si todo esto fuera poco, el auge de las estafas sofisticadas mediante deepfakes propone un escenario aún más complejo. Técnicas avanzadas de falsificación audiovisual permiten a los estafadores imitar con precisión tanto a figuras de autoridad, desde ejecutivos de empresas a líderes políticos, como a familiares directos de gente común.

Los deepfakes explotan nuestros sesgos cognitivos como el de confianza, presión temporal y urgencia, confirmación, y el realismo visual y auditivo. Apuntan como pilares básicos y profundos de nuestra psicología primigenia.

La responsabilidad para contrarrestar este fenómeno es compartida. Plataformas digitales y redes sociales tienen la obligación moral y técnica de detectar y bloquear contenidos falsos generados por IA. Paralelamente, las instituciones educativas deben priorizar la formación crítica en medios digitales desde temprana edad. Y nosotros, como miembros activos de la sociedad, tenemos el deber moral de esforzarnos por separar la paja del trigo.

Fomentar la alfabetización digital y la concientización sobre inteligencia artificial es sin duda la mejor estrategia para prevenir, pero la realidad nos apremia con tácticas de corto plazo para combatir este fenómeno:

- Al consumir noticias, buscar la validación de la misma en al menos dos fuentes de confianza. Tomémonos un momento antes de reenviar algo a otra persona, para verificar no sólo la existencia del tópico, sino también la interpretación de la fuente que la cita.

- Recomendar a los menores de edad tener perfiles de redes sociales privados, limitando el acceso a sus imágenes y videos de terceros malintencionados.

- Construir con nuestros familiares cercanos un sistema de palabras de seguridad que nos permitan validar inmediatamente la identidad de con quien hablamos.

El desafío central consiste en lograr un equilibrio entre innovación tecnológica y ética social. Nuestra capacidad individual para discernir la verdad es la última línea de defensa. Es vital generar conciencia ciudadana para que las personas aprendan a cuestionar y verificar lo que ven, escuchan y comparten en línea.

*Docente Secundario, Universitario y CEO de Varegos